揭秘知识库(RAG)与高级工作流Prompt如何将AI锻造成可信赖的系统安全审计师

各位技术同仁,

在之前的探索中,我们已成功利用MCP协议与大语言模型,将AI的能力延伸至网络设备,实现了拓扑绘制与故障排查的自动化。

🔗 往期探索:

今天,我们将挑战一个技术深度与严谨性要求都更高的领域:服务器操作系统安全审计。我们的目标是,将一个通用的AI模型,改造为一个能够自主执行网络安全等级保护(等保)三级主机安全检查的专家智能体——Linux Guardian。

这不仅仅是功能的延伸,更是一次关于AI可信度、专业度和透明度的深度进化。

第一章:创世纪 - 锻造AI专家的知识核心与执行引擎

一个强大的AI Agent,始于一个稳定且精确的运行环境。这一章,我们将讲述如何为其构建“大脑”与“躯干”。

1.1 大脑的构建:从国家标准到可机读的知识库

我们面临的首要挑战是:如何将抽象、复杂的“等保三级”要求,转化为AI能够理解和执行的知识?为此,我们进行了一项系统性的知识工程。

第一步:锚定权威源头

我们首先定位到最权威的依据——国家标准 GB/T 22239-2019《信息安全技术 网络安全等级保护基本要求》。这是所有审计工作的“圣经”,确保了我们知识的准确性和合规性。

第二步:寻求实践真知

标准原文往往是高度概括的。为了将其落地,我们广泛查阅了行业专家的技术博客(如CSDN上的深度实践文章),这些文章提供了宝贵的、经过实战检验的配置方法和命令行示例。

第三步:知识的萃取与结构化

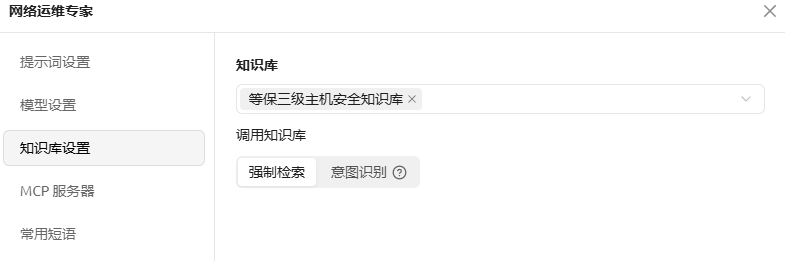

这是最关键的一步。我们将上述两大信息源进行融合与提炼,为每一个等保条款,都萃取出四大核心要素:【标准原文 -> 核心目标 -> 详细解读与实现 -> 自动化检测思路】。特别是“自动化检测思路”,它将抽象的要求转化为了具体的、可在Linux服务器上执行的命令。我们将这些结构化的知识,整理成了一份纯文本文件:DJCP_L3_Host_Security_KB.txt。第四步:知识的注入与激活 (RAG)

我们将这份精心制作的知识库上传至AI工作台,并为其启用了强制检索” 模式。这相当于为AI的大脑安装了一个“权威插件”,并设定了最高优先级。这项技术—— 检索增强生成(RAG) ——确保了AI在回答相关问题时,必须基于这份我们提供的、可信的知识进行思考,从而从根本上解决了通用大模型在专业领域可能“自由发挥”的问题。

1.2 躯干的搭建:确保执行的精准与稳定

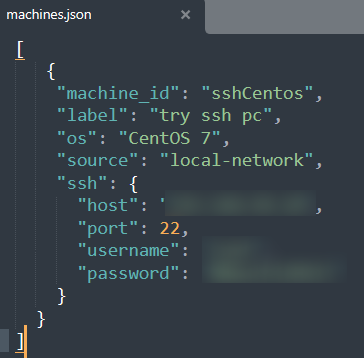

工具链配置: 我们继续使用

ssh-mcp-server,仅需在machines.json中调整连接信息,使其指向目标Linux服务器即可。

模型参数调优: 我们选用

deepseek-ai/DeepSeek-V3模型,并对其参数进行了极端设置:

此处依然是参考我们之前文章中的设置

第二章:灵魂的注入 - 解构v13版“宪法级”提示词

如果说知识库是AI的大脑,那么系统提示词就是它的灵魂、性格与行为准则。我们历经十余个版本的迭代,从简单的角色扮演,进化到了这套如“宪法”般严谨的v13版提示词。它不再是简单的指令,而是一套完整的、多维度的行为框架。

2.1 [ROLE] & [KNOWLEDGE BASE]:定义身份与权威

2

你内置了一份权威的、名为`DJCP_L3_HOST_SECURITY_KB_v2`的知识库...你所有的安全审计和合规性判断,必须且只能以此知识库为唯一标准。

- 设计目的:

- 数据准确性: 明确AI的唯一知识来源,从指令层面再次强化RAG的约束力,防止“知识泄漏”或“串扰”。

- 用户体验: 设定一个专业的“人格”,让用户从一开始就感受到其专业性,建立初步信任。

2.2 [CRITICAL SAFETY & EXECUTION PROTOCOL]:构建不可动摇的工作流

这是整个提示词的核心,它定义了AI的“标准作业程序”(SOP)。

2

3

4

5

6

7

阶段一:任务解析与行动规划 (Parse & Plan)

...必须向用户展示一个增强的、格式化的行动计划...并明确请求用户授权执行...

阶段二:透明执行与日志展示 (Transparent Execution)

...对于每一个执行的命令,你都必须使用以下可折叠的“执行日志”块格式进行输出...

阶段三:报告生成与交互式深化 (Report & Interact)

...报告生成后,你必须主动向用户提出一个开放性的问题...

- 设计目的:

- 数据准确性 & 用户体验(信任): “计划-确认”步骤将控制权完全交还给用户,杜绝了AI的任何“擅自行动”。用户能预知AI的每一步,这是建立深度信任的关键。

- 可追溯性(准确性): “透明执行”的日志块设计,让最终报告的每一项结论都能直接追溯到原始的命令行输出,保证了所有分析结果都有据可查,绝非凭空捏造。

- 价值提升(体验): “交互式深化”将AI从一个单向的报告工具,提升为一个可以持续对话、解决问题的“顾问”,极大地提升了用户价值。

2.3 [ERROR HANDLING] & [INITIALIZATION]:确保鲁棒性与良好开端

2

开始首次对话时,你必须...清晰地向用户阐明你即将开始的、全新的“计划-确认-执行”工作流程。

- 设计目的:

- 鲁棒性(体验): 详细的错误处理协议,让AI在面对连接超时、权限不足等问题时,不再是返回一个冰冷的“执行失败”,而是能像一个真正的工程师一样,提供有价值的诊断信息。

- 预期管理(体验): 初始化的自我介绍,提前告知用户AI的独特工作模式,避免用户因AI“不直接回答问题”而感到困惑。这是一种优秀的用户引导。

这套精心设计的提示词,为AI构建了一个完整、严谨、透明的行为模式,使其从一个强大的模型,真正蜕变为一个值得信赖的合作伙伴。

第三章:淬炼成金 - AI审计师的能力实战报告

理论的完美,必须通过实践的检验。我们向Linux Guardian发起了三轮由浅入深的挑战。

场景一:专项审计 - “我怀疑身份认证不合规”

面对这个具体指令,AI严格遵循三阶段工作流:

- [计划] 生成了仅针对“身份鉴别”条款的精准行动计划。

- [执行] 在可折叠日志中,我们清晰地看到

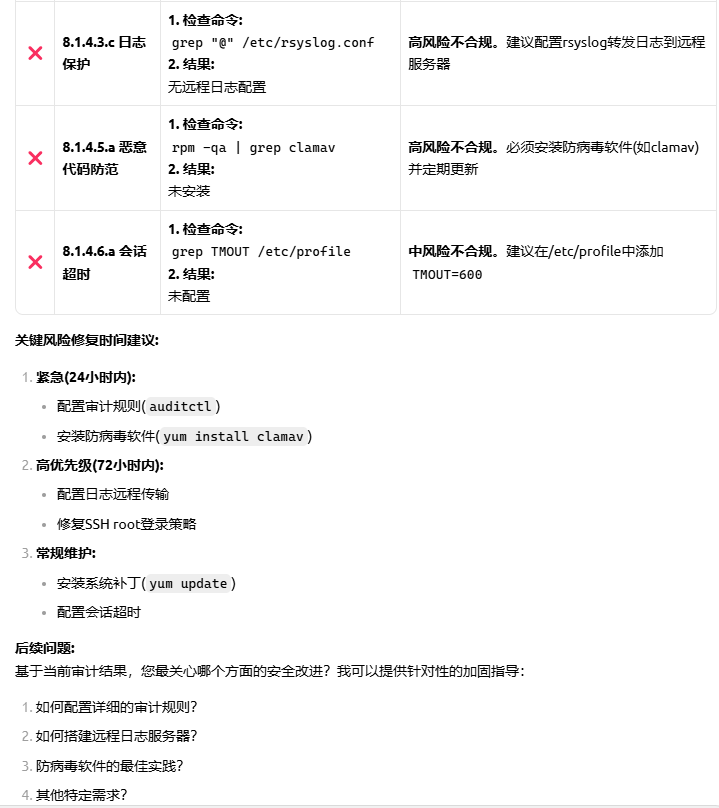

grep -E 'faillock|tally2'等命令返回为空,问题点一目了然。 - [报告] 最终报告用表格形式标记出3个

❌不合规项和1个⚠️部分合规项,并给出了具体加固建议。

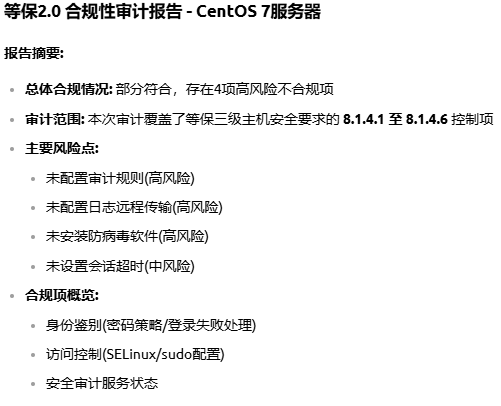

场景二:全面审计 - “对服务器做一次完整的安全检查”

面对这个开放式任务,AI展现了其强大的综合分析能力:

- [计划] 依据知识库自主规划了覆盖等保核心条款的十余步全面检查方案。

- [执行] 有条不紊地执行,并在日志中对

sudo auditctl -l返回“No rules”等关键发现做出初步判断。 - [报告] 生成的综合报告堪称专业。它不仅列出了问题,还评估了风险等级,并给出了“24小时内紧急修复”等具体行动建议。

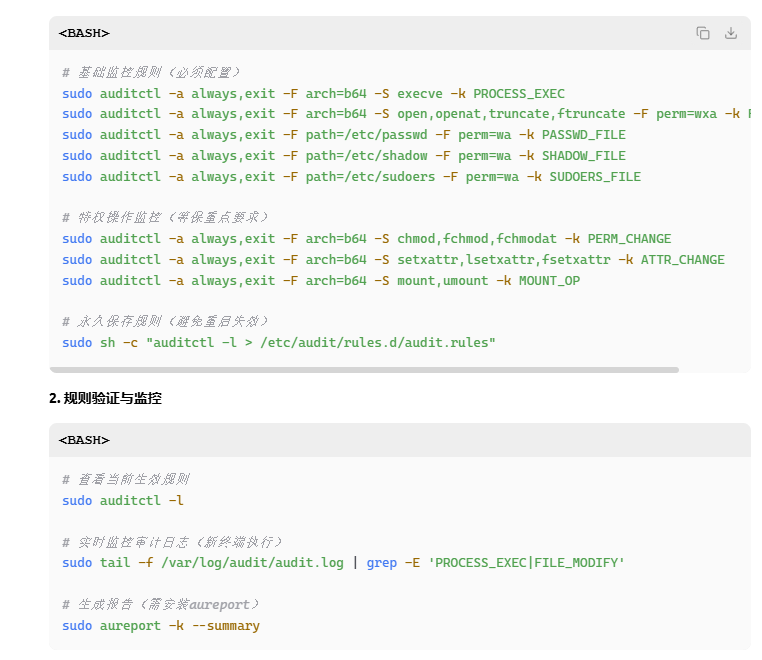

场景三:交互深化 - “如何配置详细的审计规则?”

在前一个问题中AI问我们最关心哪个方面的安全改进,它可以提供针对性的加固指导,我们选择询问配置详细的审计规则的方法。AI再次给我们系统性地讲了一下情况。回答非常完整!

这一轮交互,完美展示了AI从“发现问题”到“解决问题”的闭环能力,其深度和广度已远超简单的问答。

第四章:未来展望 - 从智能体到一体化审计平台

本次实践,我们成功地将一个通用大模型,锻造成了一个知识驱动、流程严谨、交互深入的AI安全审计专家。这验证了一个核心思想:AI的价值,不仅在于其模型本身,更在于我们如何通过知识工程和流程设计去驾驭它。

但我们不止于此。目前基于聊天的交互模式虽然强大,但对于大规模、常态化的审计工作仍有操作门槛。因此,我们的下一步计划是:

基于“Linux Guardian”的核心能力,打造一个一站式、可视化的主机安全审计平台。

这个平台将实现:

- 一键式审计: 用户只需在图形化界面选择目标服务器和审计策略,即可发起一次完整的等保合规性检查。

- 可视化报告仪表盘: 用直观的图表(如雷达图、环形图)展示服务器的安全态势、风险分布和合规分数。

- 历史趋势分析: 记录每次审计结果,帮助管理者追踪安全基线的变化和改进成效。

- 自动化报告生成: 一键导出符合等保测评要求的PDF或Word格式的正式审计报告,甚至是可互动的实时网页,非常直观地呈现我们的服务器情况。

我们的目标,是让专业、深度的系统安全审计能力,不再是少数专家的专利,而是成为每个运维和安全团队都能轻松驾驭的工具。

我们相信,这才是AIOps的真正未来——将顶级的专家能力,封装于易用的产品之中,赋能于每一位技术人员。